ollama本地部署qwen大模型

ollama本地部署qwen大模型

Ollama是一款高效的计算库,专门为处理和部署机器学习模型而设计,支持将复杂的模型轻松迁移到本地环境中运行。本教程将重点介绍如何使用Ollama将预训练的模型下载到您的计算机,并在本地环境中成功部署和运行这些模型。我们将通过详细的步骤解释如何配置本地环境、加载模型以及进行必要的性能调优。无论您是希望进行模型的开发测试还是需要进行大规模的数据处理,Ollama都能提供必要的工具和框架,帮助您高效完成任务。通过本教程,您将能够充分利用Ollama在本地环境中实现模型的快速部署和高效运行。

前期工作

-

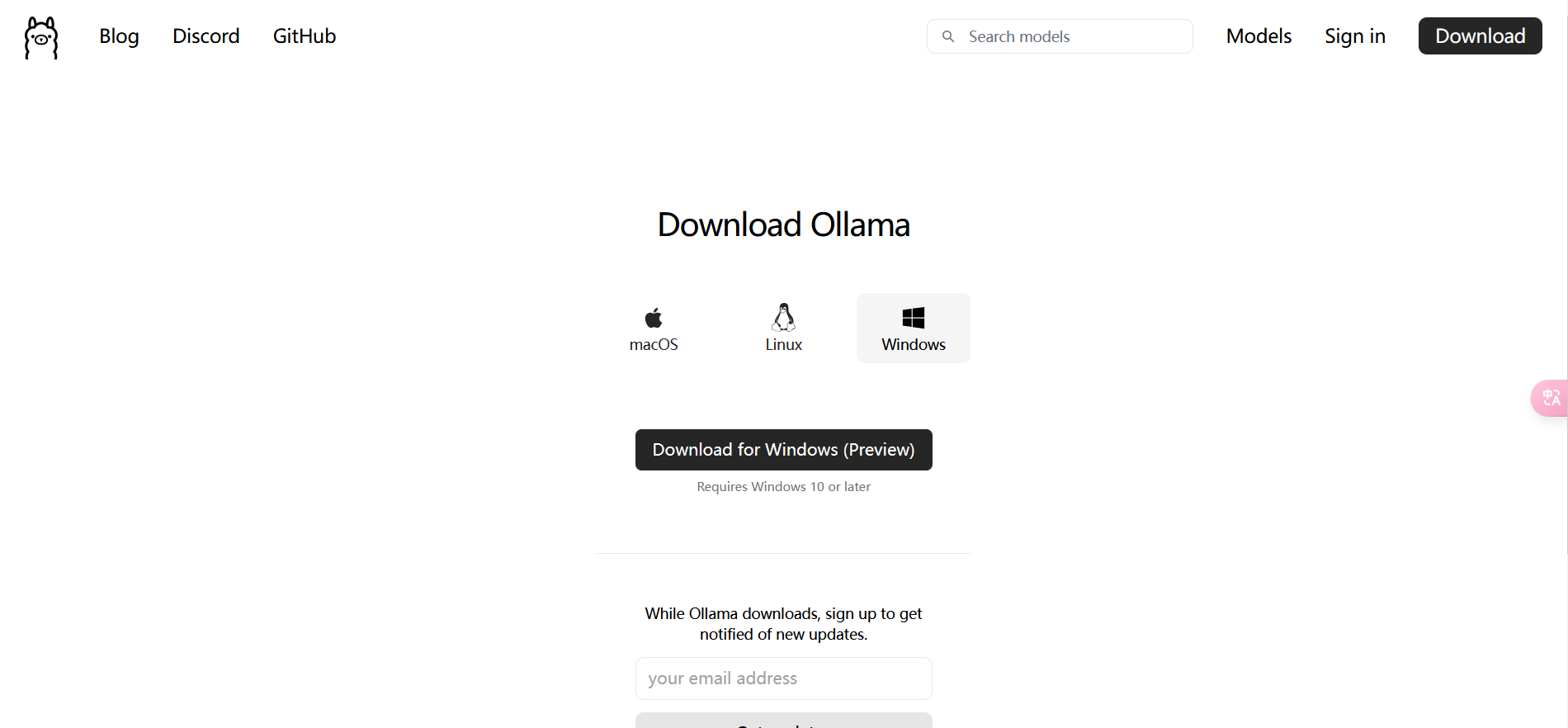

Ollama官网,下载安装Ollama https://ollama.com/download

-

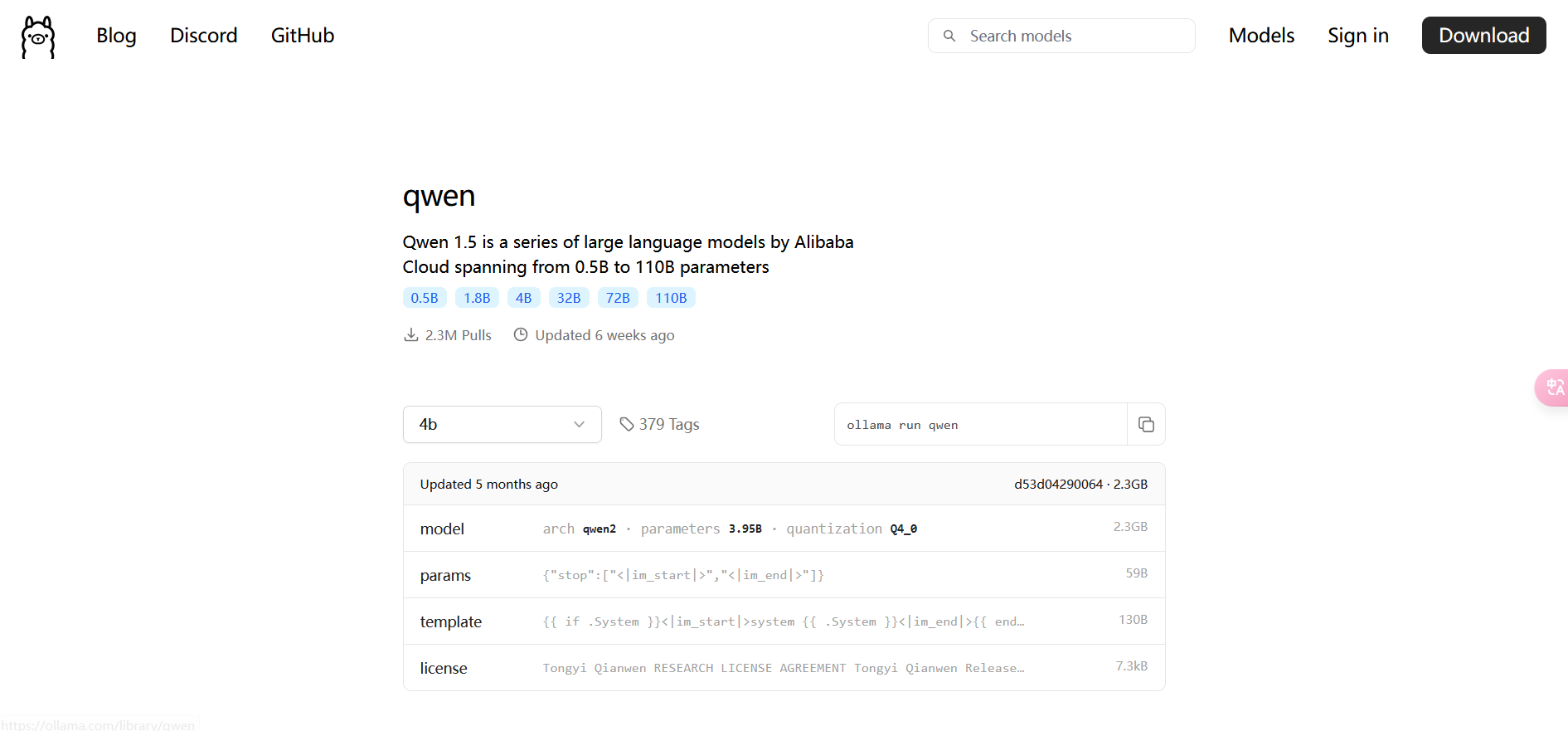

Ollama官网右上角选择qwen,然后选择自己电脑配置合适的数据量(7B -- > 8G运行内存)

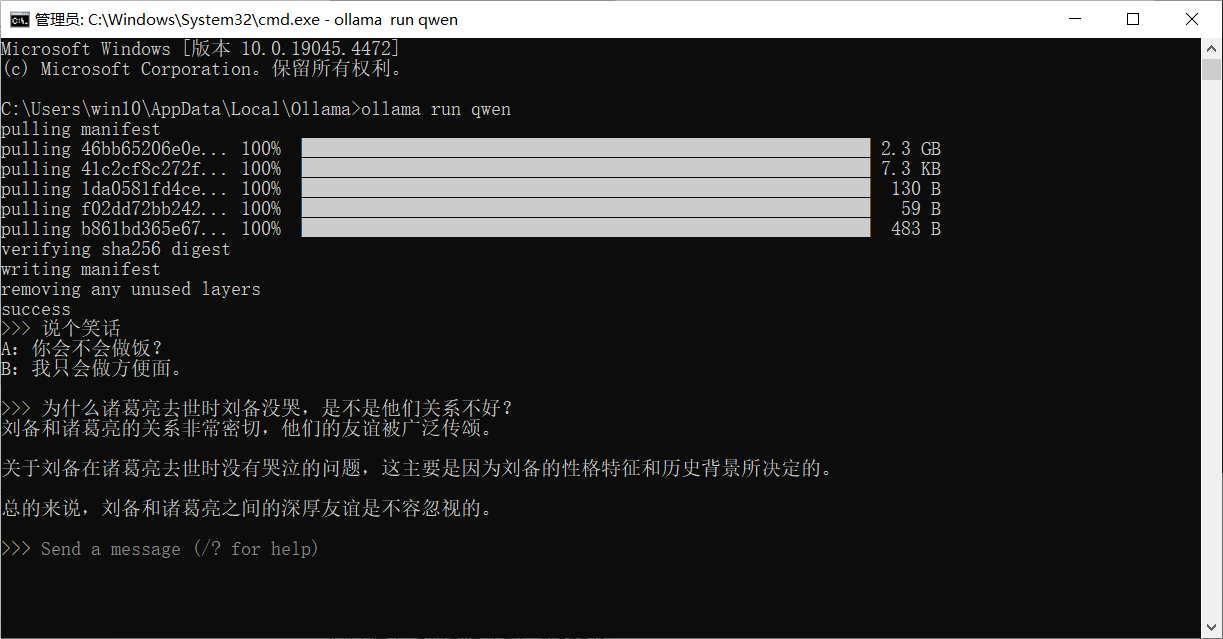

下载运行大模型

-

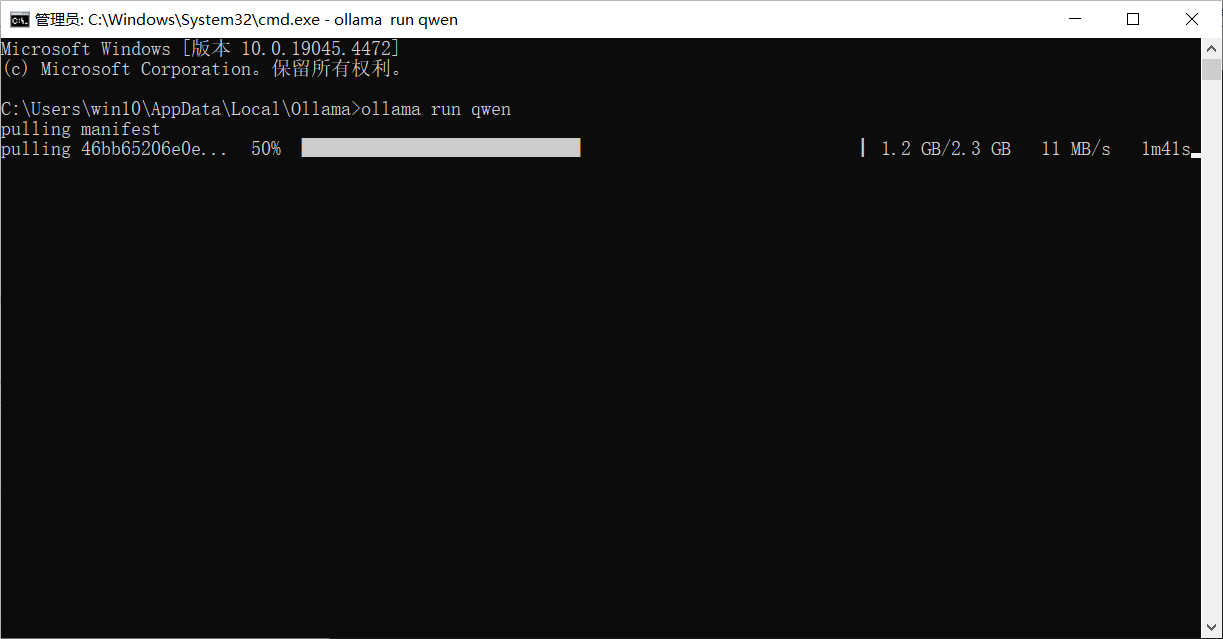

运行Ollama程序,在右击Ollama图标,选择

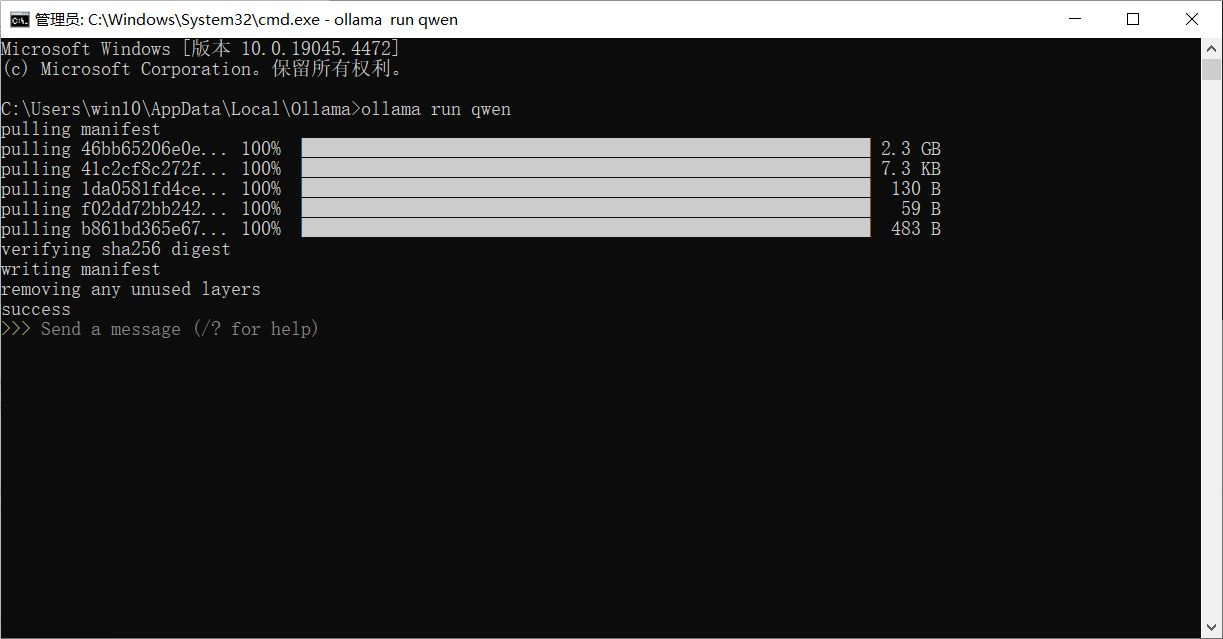

View logs,然后打开cmd命令行,输入命令,等待下载和运行模型

-

完成

-

可以向它提问,我选择的这个模型数据量比较少,所以很笨

-

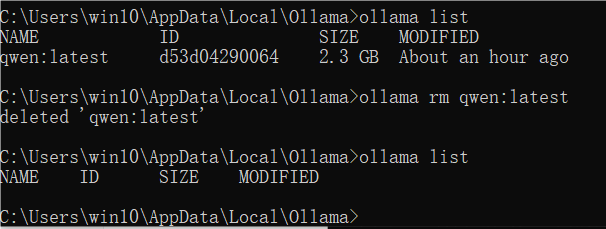

不想用了就可以把它删掉

基本命令

- 运行模型

ollama run <model> - 创建模型

ollama create <name> -f <modelfile> - 查看本地模型列表

ollama list - 删除模型

ollama rm <model>

广告

自己搭建的大模型合集中转站点 https://api.zukedog.cn 支持的模型很多:

- claude-3-5-sonnet-20240620

- gpt-4-turbo-2024-04-09

- gpts

- gpt-4o-2024-05-13

- ......

版权申明

本文系作者 @卸了磨的驴 原创发布在ollama本地部署qwen大模型。未经许可,禁止转载。

全部评论